Avevamo bisogno di una regolamentazione che arrivasse dalla Comunità Europea?

Mi verrebbe da dire “sì. perché noi da soli non siamo in grado di farla”. Mi in realtà è opportuno che sia governata dalla Comunità Europea per la destinazione d’uso.

Nel febbraio del 2024 è stato istituito un Ufficio Europeo per l’Ai.

L’Ufficio sovrintende all’applicazione e all’attuazione della legge sull’IA con gli Stati membri. Mira a creare un ambiente in cui le tecnologie di IA rispettino la dignità umana, i diritti e la fiducia. Promuove inoltre la collaborazione, l’innovazione e la ricerca in materia di IA tra i vari portatori di interessi. Inoltre, si impegna nel dialogo e nella cooperazione internazionali sulle questioni relative all’IA, riconoscendo la necessità di un allineamento globale sulla governance dell’IA. Attraverso questi sforzi, l’Ufficio europeo per l’IA si sforza di posizionare l’Europa come leader nello sviluppo etico e sostenibile delle tecnologie di IA.

Il Regolamento 2024/1689, pubblicato sulla Gazzetta Ufficiale il 12 luglio 2024, entrato in vigore il 02 agosto 2024, sostanzialmente definisce i limiti di utilizzo, di generazione e di identificazione di contenuti Ai.

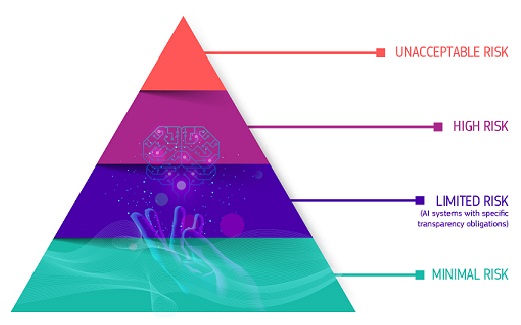

La regolamentazione ha individuato 4 diversi livelli di rischio e li analizza mettendo in pista le soluzioni da adottare per non essere inadempienti.

Rischio elevato

I sistemi di IA identificati come ad alto rischio comprendono la tecnologia di IA utilizzata in:

- infrastrutture critiche (ad esempio i trasporti), che potrebbero mettere a rischio la vita e la salute dei cittadini

- formazione scolastica o professionale, che può determinare l’accesso all’istruzione e al corso professionale della vita di una persona (ad esempio il punteggio degli esami)

- componenti di sicurezza dei prodotti (ad es. applicazione dell’IA nella chirurgia assistita da robot)

- occupazione, gestione dei lavoratori e accesso al lavoro autonomo (ad esempio software di selezione dei CV per le procedure di assunzione)

- servizi pubblici e privati essenziali (ad esempio il credit scoring che nega ai cittadini la possibilità di ottenere un prestito)

- attività di contrasto che possono interferire con i diritti fondamentali delle persone (ad esempio valutazione dell’affidabilità delle prove)

- gestione della migrazione, dell’asilo e del controllo delle frontiere (ad esempio esame automatizzato delle domande di visto)

- amministrazione della giustizia e processi democratici (ad esempio soluzioni di IA per la ricerca di decisioni giudiziarie)

I sistemi di IA ad alto rischio sono soggetti a obblighi rigorosi prima di poter essere immessi sul mercato:

- adeguati sistemi di valutazione e mitigazione dei rischi

- alta qualità delle serie di dati che alimentano il sistema per ridurre al minimo i rischi e i risultati discriminatori

- registrazione dell’attività per garantire la tracciabilità dei risultati

- documentazione dettagliata che fornisca tutte le informazioni necessarie sul sistema e sul suo scopo affinché le autorità ne valutino la conformità

- informazioni chiare e adeguate per l’operatore

- adeguate misure di sorveglianza umana per ridurre al minimo i rischi

- alto livello di robustezza, sicurezza e precisione

Tutti i sistemi di identificazione biometrica remota sono considerati ad alto rischio e soggetti a requisiti rigorosi. L’uso dell’identificazione biometrica remota in spazi accessibili al pubblico a fini di contrasto è, in linea di principio, vietato.

Sono rigorosamente definite e regolamentate eccezioni limitate, ad esempio quando necessario per cercare un minore scomparso, prevenire una minaccia terroristica specifica e imminente o individuare, localizzare, identificare o perseguire l’autore o il sospettato di un reato grave.

Tali usi sono subordinati all’autorizzazione di un organo giudiziario o di un altro organo indipendente e a limiti adeguati per quanto riguarda il tempo, la portata geografica e le banche dati consultate.

Rischio limitato

Il rischio limitatosi riferisce ai rischi associati alla mancanza di trasparenza nell’uso dell’IA. La legge sull’IA introduce specifici obblighi di trasparenza per garantire che gli esseri umani siano informati quando necessario, promuovendo la fiducia. Ad esempio, quando si utilizzano sistemi di intelligenza artificiale come i chatbot, gli esseri umani dovrebbero essere consapevoli del fatto che stanno interagendo con una macchina in modo che possano prendere una decisione informata di continuare o fare un passo indietro. I fornitori devono inoltre garantire che i contenuti generati dall’IA siano identificabili. Inoltre, il testo generato dall’IA pubblicato allo scopo di informare il pubblico su questioni di interesse pubblico deve essere etichettato come generato artificialmente. Ciò vale anche per i contenuti audio e video che costituiscono deep fake.

Rischio minimo o nullo

La legge sull’IA consente l’uso gratuito dell’IA a rischio minimo. Ciò include applicazioni come videogiochi abilitati all’intelligenza artificiale o filtri antispam. La stragrande maggioranza dei sistemi di IA attualmente utilizzati nell’UE rientra in questa categoria.

Tutto questo quanto impatta con la fotografia?

E soprattutto, quanto tiene di conto della proprietà intellettuale sulla quale l’educazione di una intelligenza artificiale si basa e genera la propria base evolutiva?

Scrivetelo nei commenti.

Lascia un commento